03/10/2025

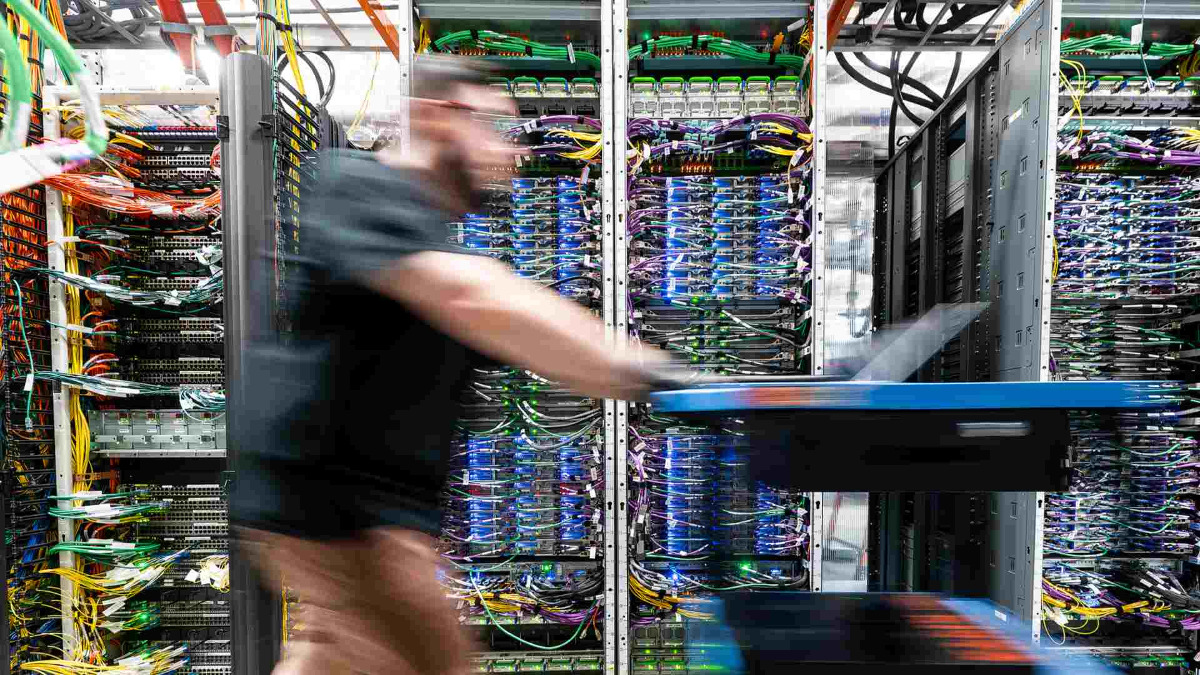

NVIDIA霸權終結?4大雲端巨頭發動「去GPU化」革命!黃仁勳如何守住AI龍頭寶座?

在生成式AI浪潮持續發酵下,輝達(NVIDIA)將不再是AI舞台上的唯一主角。Google、Meta、亞馬遜、微軟四大雲端巨頭,正加速製造自研ASIC晶片,意圖擺脫對NVIDIA GPU的依賴。這場「去GPU化」革命,不僅讓ASIC設計公司的角色愈顯重要,更揭示一門價值數百億美元的新興產業正在醞釀中。面對來勢洶洶的ASIC陣營,輝達執行長黃仁勳究竟有何良策?AI晶片產業版圖又會有甚麼翻天覆地的改變?

輝達AI帝國動搖?OpenAI百億投單博通,押注ASIC晶片,能否威脅NVIDIA GPU霸業?

黃仁勳雙重豪賭:千億押注OpenAI、50億金援Intel!解讀NVIDIA巨額投資背後的深遠布局!

稱霸AI晶片!NVIDIA吃掉9成AI利潤,科技巨頭尋找替代方案!未來競爭格局將面臨巨變?

ASIC市場規模達300億美元

「ASIC」意指「特殊應用積體電路」(Application Specific Integrated Circuit),有別於通用型晶片如CPU(中央處理器)和GPU(圖形處理器),ASIC是專為應付特定任務而設計的客製化晶片。

追溯ASIC的發展脈絡,最早始於1970年代,到了1980至1990年代曾風光一時,但因設計門檻高、成本昂貴,後來被更具彈性的通用型晶片取而代之。隨著近年生成式AI爆紅,全球對AI晶片的需求急增,ASIC開始再受重視。摩根大通評估,2025年全球適用於AI運算的ASIC市場規模,將成長至300億美元(約2,340億港元),更預測未來每年平均增長率將逾30%。

雖然GPU在AI運算上具有強大效能,但面對日益多樣化與專業化的AI應用,ASIC能針對特定任務量身訂做的優勢開始顯露出來。例如在AI模型的推論過程中,ASIC可以展現出更高的運算效率與更佳的能耗表現;加上大規模部署後可分攤開發成本,使其總體擁有成本有機會低於NVIDIA GPU。

Google自研ASIC進度領先

NVIDIA GPU擅長平行運算,優於AI模型訓練和推論,而其專屬AI開發工具平台《CUDA》,現已成為AI開發上不可或缺的底層軟件,讓AI工程師離不開「GPU + CUDA」的黃金組合。因此,無論是科技巨頭或初創公司,若要開發AI模型,均首選NVIDIA GPU,以致在供貨和議價方面長期居於下風。

為減少對NVIDIA GPU依賴和壓低採購成本,Google、Meta、亞馬遜(Amazon)、以及微軟(Microsoft),已先後研發自家ASIC晶片,掀起一場「去GPU化」革命。在ASIC賽道上,Google以先行者的姿態暫時領先。

Google早於2015年已秘密研發可供AI使用的ASIC晶片,名稱為「TPU」(Tensor Processing Unit);2016年,首次在公開場合介紹TPU的存在。來到2025年,Gemini模型75%運算工作已由TPU執行,在四大雲端巨頭中對NVIDIA GPU的依賴最少。2026年下半年,由博通(Broadcom)與聯發科攜手設計的第七代TPU v7將大量投入使用,可望進一步降低對輝達的依賴。

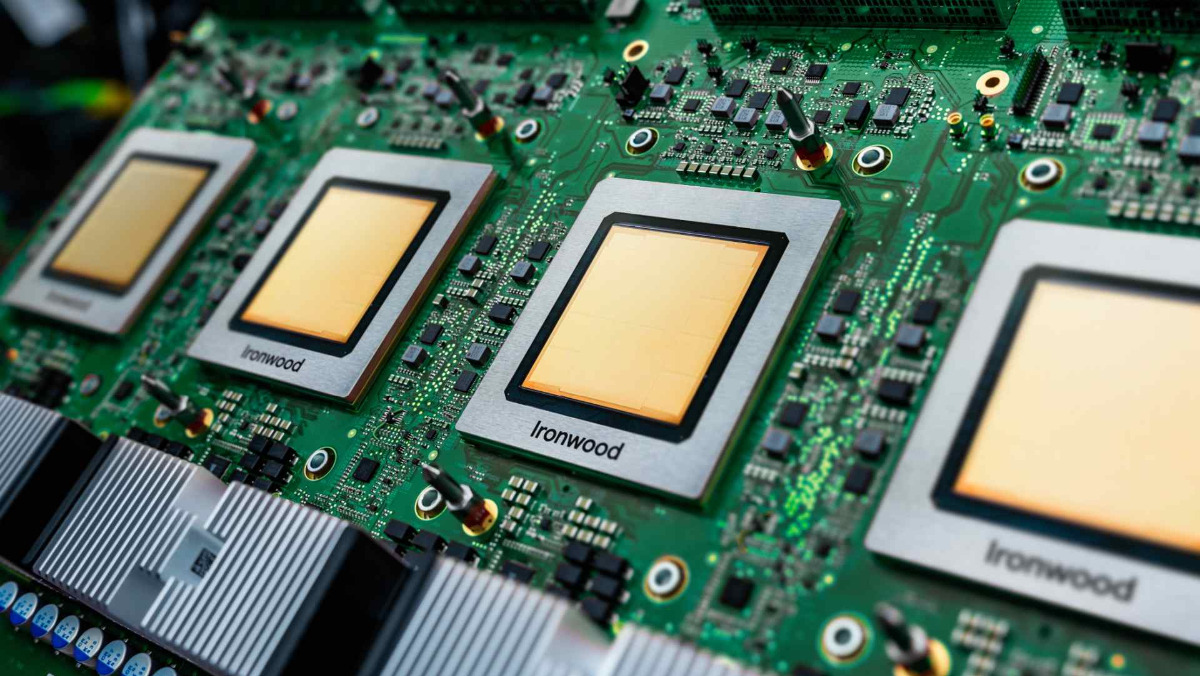

Google第七代TPU的代號為「Ironwood」,是旗下首款專為AI推論而設計的自研晶片,將於2026年下半年量產。(圖片來源:Google Cloud官方網誌)

Meta、微軟研發進程稍為落後

Amazon自研AI晶片「Trainium」現已發展至第二代,根據摩根士丹利的研究,Trainium在執行AI推論時,成本比NVIDIA H100 GPU低上30%至40%。可是,其AI雲端平台75%運算力都來自NVIDIA GPU,對輝達依賴程度依然偏高。第三代Trainium3由世芯電子與邁威爾(Marvell)合作設計,其效能將是前代的兩倍,耗電量亦減少50%,預計於2026年量產。

Amazon旗下超級電腦「Rainier」是由數十萬顆Trainium晶片組成的超大型AI運算平台,可用於支援Anthropic Claude大型語言模型訓練。(圖片來源:Amazon官網)

相較之下,Meta與微軟較晚加入自研晶片行列,所以進度稍為落後。Meta的ASIC晶片「MTIA」只佔自家平台運算力約15%,對NVIDIA GPU存有高度依賴。第二代MTIA v2由博通設計,運算速度較前代提升3倍,能支援更高運算密度,預計2025年下半年量產。

微軟對NVIDIA GPU的依賴程度最高,運算力佔比高達90%,自研晶片「Maia」僅佔10%。微軟技術長凱文·斯科特(Kevin Scott)表示,長遠目標是希望旗下數據中心以自研晶片為運算主力,務求擺脫對輝達的依賴。第二代Maia 200由博通設計,針對微軟新一代數據中心架構進行優化,原計劃在2025年投產,惟傳出將延後至2026年。

微軟技術長斯科特表示,雖然NVIDIA GPU是性價比最高的解決方案,但為確保未來有足夠運算力可供使用,未來微軟數據中心將使用自研晶片為主。(圖片來源:維基百科)

開放NVLink拉攏ASIC設計商

日本野村證券預估,2025年Google TPU出貨量將達到150萬至200萬顆,亞馬遜ASIC出貨量則為140萬至150萬顆,兩者合計已相當於NVIDIA GPU每年供應量的一半。及至2026年,Meta與微軟的自研晶片陸續供貨,AI ASIC總出貨量有望超越NVIDIA GPU。

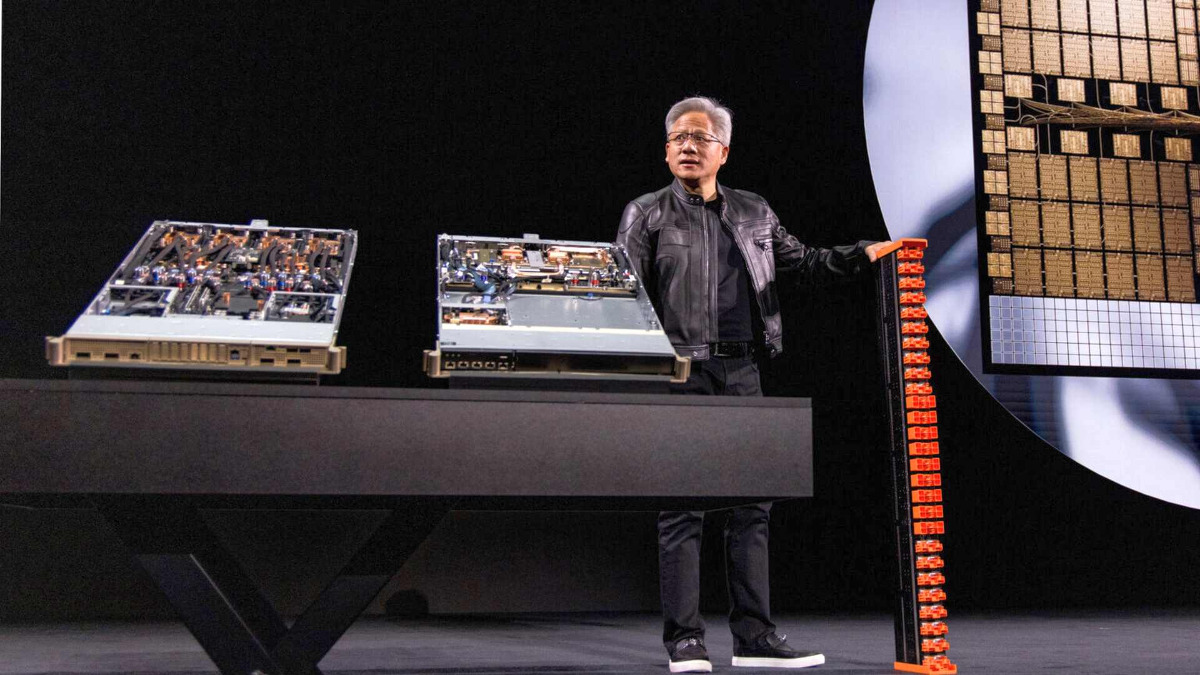

面對「去GPU化」危機,黃仁勳的應對方法是推出「NVLink Fusion」策略,藉此向業界開放其獨門NVLink互連技術協定,容許第三方CPU或ASIC能夠輕易連接NVIDIA GPU,讓其他業者可以利用NVLink,創建半客製化的AI基礎架構。高通(Qualcomm)、邁威爾、聯發科、世芯電子、以及富士通(Fujitsu)等主要ASIC設計商,都已成為合作夥伴。

此舉被視為拉攏ASIC設計商加入NVIDIA GPU陣營,以防止四大雲端巨頭完全撤出輝達AI運算平台。須知道Google、Meta、亞馬遜、微軟的強項是軟件開發,如要實現自研晶片,非要有ASIC設計商的協助不可;當大部分設計公司積極擁抱NVLink Fusion,其客戶(雲端巨頭)也會留在輝達生態系統之內。

投資OpenAI掌控AI基建發展

事實上,輝達以最強運算力的GPU硬件,配搭最成熟的開發軟件《CUDA》,得以凝聚全球最龐大的AI開發者社群;這個由黃仁勳精心打造逾15年的生態系統,絕非ASIC陣營可以在短期內攻克。因此,NVIDIA GPU在AI領域始終有無可替代的角色,在NVLink對外開放後,將會深化GPU與ASIC之間的互補關係,預計未來在AI伺服器部署上將出現雙軌並行的情況。

更重要的一著棋是,NVIDIA向OpenAI投資1,000億美元(約7,800億港元),等於繞過微軟,直接跟後者結盟,成為其核心策略夥伴,足以左右其AI基建發展路徑——OpenAI已承諾興建規模達10GW的GPU數據中心。如此一來,即使雲端巨頭加速自研晶片,輝達依然能穩居AI生態鏈的關鍵位置。

黃仁勳強調,AI市場競爭的關鍵不是「哪顆晶片比較便宜」,而是「哪家AI工廠比較賺錢」。NVIDIA正在做的是設計和建造「AI工廠」,內裡包含GPU、CPU、NVLink、以及《CUDA》。(圖片來源:NVIDIA官網)

然而,輝達的市場份額卻難免受到影響。市調機構TrendForce評估,在基於GPU的AI伺服器市場,NVIDIA現握有逾90%市佔率;隨著AI ASIC出貨量不斷增加,未來輝達市佔率可能下滑到70%至80%,ASIC佔比則有機會攀升到20%或以上。表面看來,NVIDIA似乎流失了市場份額,其實這只是大家一起把AI市場的餅做大了,再重新分配佔比;實際上,輝達的獲利和主導地位不見得受損,依然可以穩坐在AI龍頭寶座之上。

《經濟通》所刊的署名及/或不署名文章,相關內容屬作者個人意見,並不代表《經濟通》立場,《經濟通》所扮演的角色是提供一個自由言論平台。

【你點睇?】美國聯邦政府再停擺或令關鍵經濟數據無法按時發布,你認為會否對股市造成負面影響?► 立即了解